在机器人学习(robot learning)领域,如何高效且稳定地从高维感知输入生成复杂的决策动作,一直是技术发展的核心难题。扩散策略(Diffusion Policy [1])凭借其优秀的多峰分布建模能力,使得机器人能够以多种方式完成同一任务,避免陷入某一种行为模式(mode collapse), 极大提升了灵活性和表达能力。

然而,扩散模型也有一大痛点:推理效率极低。每次生成动作时,都需要从噪声一步步去噪,反复执行几十步反向过程,才能获得最终决策。在真实机器人需要高速响应的场景下,这种低效的采样方式,成为了落地应用的最大障碍。Falcon(Fast Visuomotor Policies via Partial Denoising),正是一项打破扩散策略速度瓶颈的创新,他能在无需额外训练、无损策略多样性的前提下,有效减少扩散采样步数,实现 2–7 倍的推理加速,为未来机器人领域中以扩散策略为核心的通用策略模型提供了更现实的落地路径,也有望推动具身策略算法在实际任务中的广泛应用。

论文标题|Falcon: Fast Visuomotor Policies via Partial Denoising

论文地址|https://arxiv.org/abs/2503.00339

开源代码|https://github.com/chjchjchjchjchj/Falcon

扩散策略的

加速困局

扩散策略的

加速困局

为了加速扩散策略的采样速度,利用ODE求解器的一类方法(如DDIM[3], DPMSolver[4])将扩散策略的采样过程表示为ODE,然后利用解ODE的方法来减少采样步数,但他们在步数太少时成功率明显下降。另一类蒸馏的方法(如Consistency Policy[5])干脆将扩散策略蒸馏成一个的“快模型”,但这种方法可能会丧失原始模型表达多峰分布的能力,还要针对每个任务单独蒸馏才能实现加速效果。

本质上,现有加速方法只是在每个时间步 t 上提速,即如何更快地得到 A_t | O_t。但在机器人视觉运动任务里,动作和动作之间有很强的时序依赖性(抓起物体、移动到目标位置、放置这几个动作是衔接紧密的)。如果我们能利用好“动作之间的时序一致性”,也许可以在“轨迹层面”整体提速!

Falcon 的核心创新:

历史助力、高效生成

Falcon 的核心创新:

历史助力、高效生成

| Falcon:“我不从纯噪声开始生成动作了,我利用历史的半去噪的动作开始生成动作。”

参考动作:

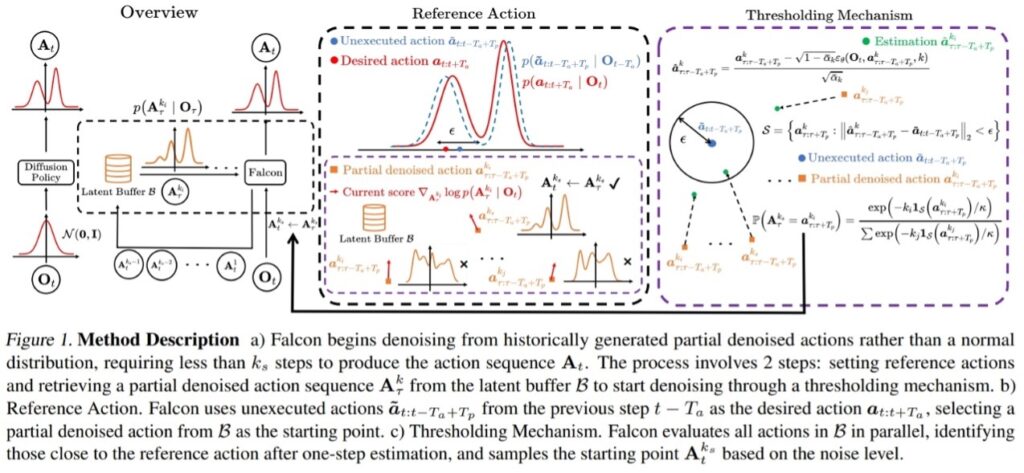

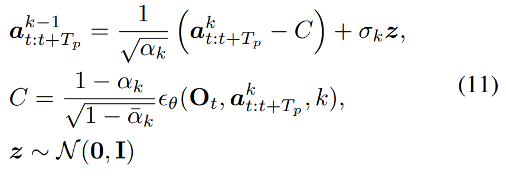

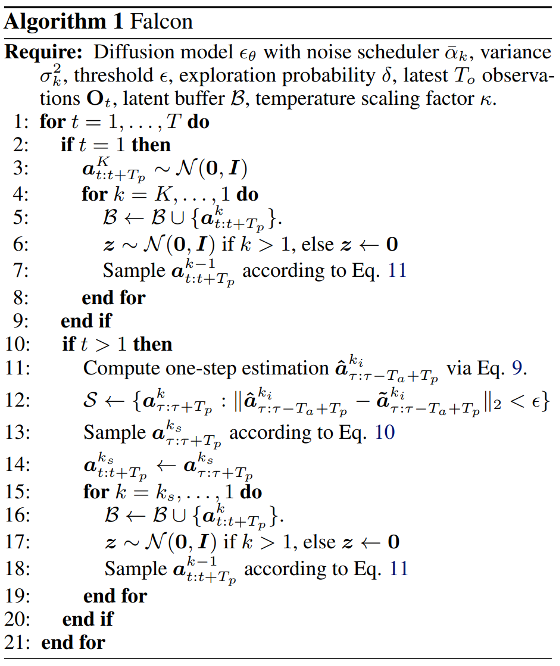

扩散策略在每个时间步 t 接收 T_o 个历史观测值 O_t ,根据 Eq. 11(DDPM[2])经过 K 步迭代

生成一个长度为 T_p 的动作序列 A_t=[a_(t:t+T_a ),a ̃_(t+T_a:t+T_p ) ],最后执行前 T_a 个动作 a_(t:〖t+T〗_a )。Falcon 利用没有执行的动作序列 a ̃_(t+T_a:t+T_p ) 作为半去噪动作的参考动作,表示在时间步骤 〖t+T〗_a 动作生成的大致目标区域。

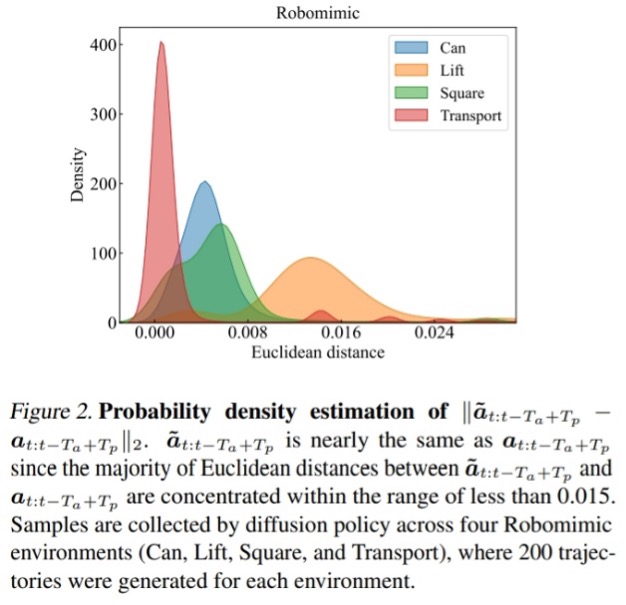

为什么这样可行?因为:1. 扩散策略 p_θ (A_t∣O_t ) 训练的时候就是以长度为 T_p 的动作序列作为监督信号的 2. 我们惊讶地发现 a ̃_(t+T_a:t+T_p ) 与 a_(t+T_a:t+T_p ) 差异不大,这表明二者的分布接近,模型对前一步的预测是有信心的。

阈值选择机制:

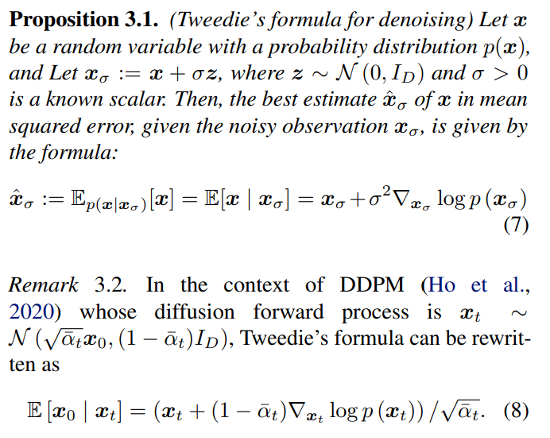

为了决定哪个历史的半去噪动作作为当前动作的初始化,Falcon 引入了 Tweedie 公式:

具体来说:

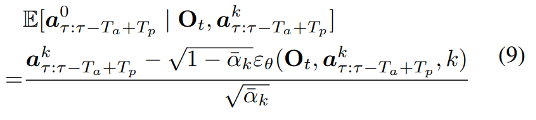

1. 计算所有半去噪动作序列 a_(τ:τ-T_a+T_p)^k 在基于 O_t 的后验期望 E[a_(τ:τ-T_a+T_p)^0∣O_t,a_(τ:τ-T_a+T_p)^k ] 作为一步估计得到 a ̂_(τ:τ-T_a+T_p)^(k_i ),其中 τ<t。

2. 如果某个估计结果 a ̂_(τ:τ-T_a+T_p)^(k_i ) 和参考动作 a ̃_(t+T_a:t+T_p ) 的欧氏距离小于阈值 ϵ ,则说明这个历史样本“有用”。

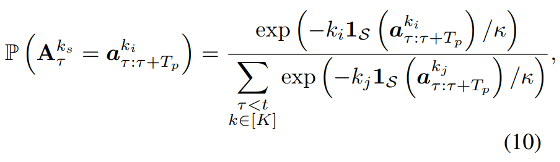

3. 从所有满足阈值的候选样本集合 S={a_(τ:τ+T_p)^k:‖a ̂_(τ:τ-T_a+T_p)^k-a ̃_(τ:τ-T_a+T_p ) ‖_2<ϵ,∀τ<t,k∈[K]} 中,Falcon 使用 softmax 选择最合适的初始动作,而不是硬选择最小距离。

为了保持一定的探索性,它还引入 ϵ-greedy策略[7],在一定概率 δ 下直接从高斯分布 N(0,I) 采样,防止局部最优。历史的半去噪动作会被存储到Latent Buffer B 里,为了不消耗过多显存,Falcon使用优先队列来实现 Latent Buffer,会优先移除时间早或者噪声等级大的样本,保证高效又节省资源。

这种设计和 ODE Solver、蒸馏方法是正交的:前者关注“每一时刻动作采样本身如何快”,而 Falcon 关注“轨迹之间如何用历史信息缩短当前步的采样距离”,因此它可以直接与现有 ODE Solver 结合,进一步叠加提速效果。

实验

结果

实验

结果

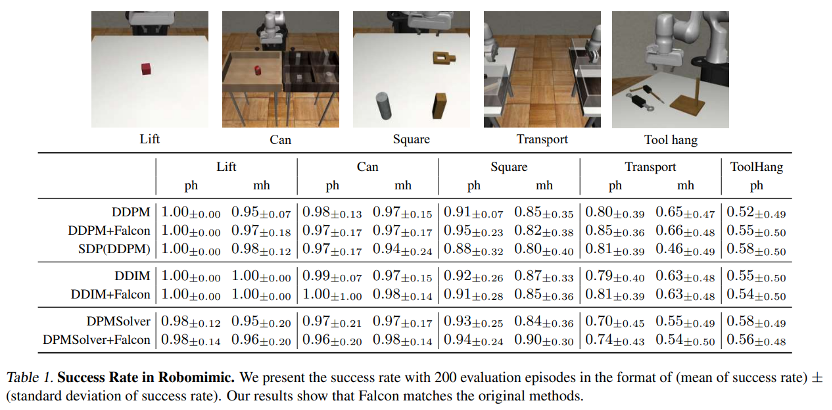

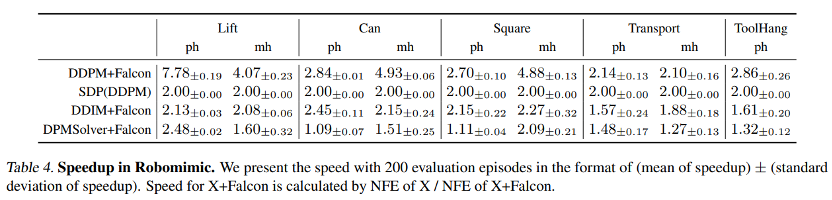

实验主要比较了DDPM[2], SDP[6], DDIM[3]和DPMSolver[4]。

模拟环境:

在Robomimic环境中,Falcon 能提速 2-7x,在配合DDIM和DPMSolver的情况下,也能在原基础上提升2倍加速。

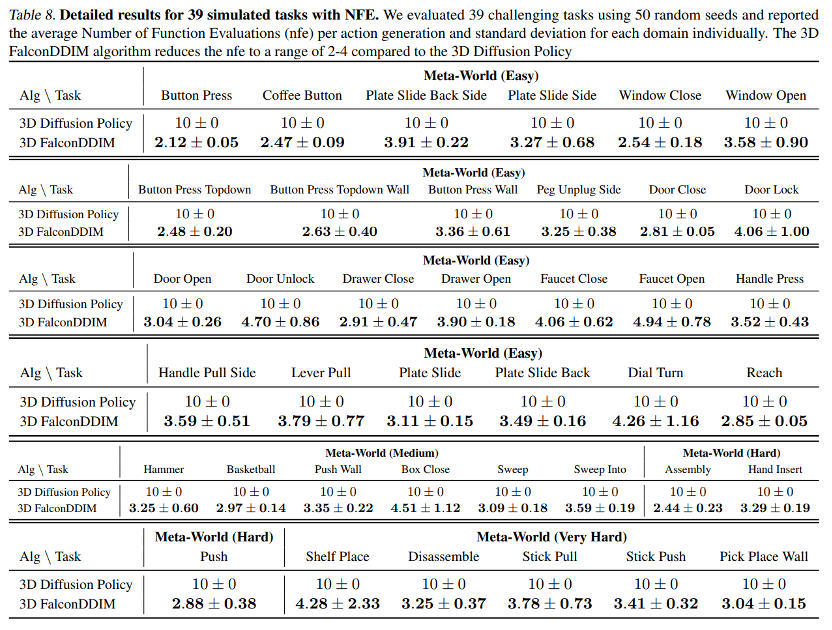

在MetaWorld中,Falcon与3D Diffusion Policy比较(采样步数为10的DDIM),也能提速2-4x。

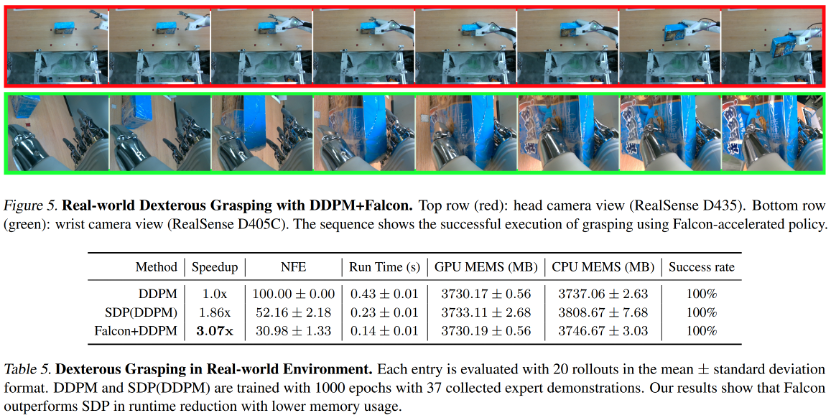

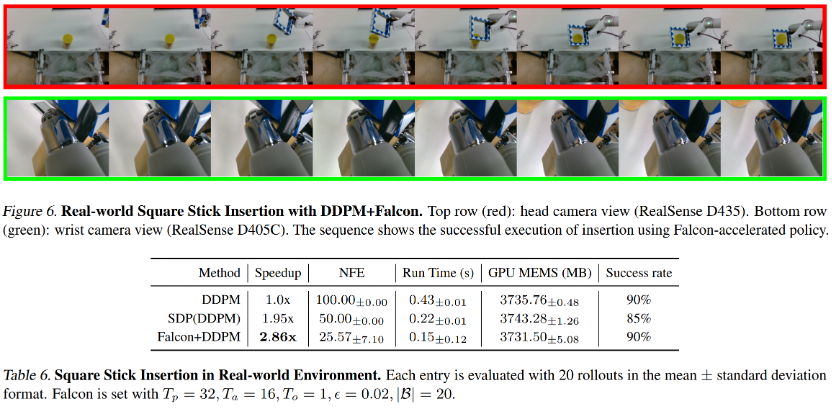

真实世界的灵巧操作:

Falcon 在灵巧抓取和方柱插入两个真实场景部署中也能提升2-3x的加速,相比SDP能更快并且更加节省空间资源。

保留多峰分布的表达能力:

在 pushT 环境中,Falcon 能既从左边推木块又能从右边推木块,依旧具有多峰分布的表达能力,而Consistency Policy 则倾向于从一侧推木块。

本文共同第一作者是北京大学智能学院博士生陈浩钧、信息科学技术学院本科生刘明灏,通讯作者是北京大学人工智能研究院杨耀东助理教授和北京通用人工智能研究院李庆研究员。

参考资料:

[1] Chi, Cheng, et al. “Diffusion policy: Visuomotor policy learning via action diffusion.” The International Journal of Robotics Research (2023): 02783649241273668.

[2] Ho, Jonathan, Ajay Jain, and Pieter Abbeel. “Denoising diffusion probabilistic models.” Advances in neural information processing systems 33 (2020): 6840-6851.

[3] Song, Jiaming, Chenlin Meng, and Stefano Ermon. “Denoising diffusion implicit models.” arXiv preprint arXiv:2010.02502 (2020).

[4] Lu, Cheng, et al. “Dpm-solver: A fast ode solver for diffusion probabilistic model sampling in around 10 steps.” Advances in Neural Information Processing Systems 35 (2022): 5775-5787.

[5] Prasad, Aaditya, et al. “Consistency policy: Accelerated visuomotor policies via consistency distillation.” arXiv preprint arXiv:2405.07503 (2024).

[6] Høeg, Sigmund H., Yilun Du, and Olav Egeland. “Streaming Diffusion Policy: Fast Policy Synthesis with Variable Noise Diffusion Models.” arXiv preprint arXiv:2406.04806 (2024).

[7] Sutton, Richard S., and Andrew G. Barto. Reinforcement learning: An introduction. Vol. 1. No. 1. Cambridge: MIT press, 1998.

原文链接:https://arxiv.org/abs/2503.00339?sessionid=