导读:2025年全球开发者先锋大会上,灵初智能(PsiBot)作为国内唯一受邀的具身大模型企业,首次系统性展示其行业领先VLA大模型,及其泛化操作能力、长程任务思考能力。公司创始人兼CEO王启斌现场解析灵初智能如何基于强化学习通过多模态穿透、零样本泛化、长程任务串联,突破具身智能的“最后一公里”瓶颈,为制造业、服务业等场景提供真正“替人”的通用智能解决方案。

Psi-R0是灵初智能发布的首个基于强化学习(RL)的端到端具身模型。该模型支持双灵巧手协同进行复杂操作,将多个技能串联混训,生成具有推理能力的智能体,可以实现从感知到执行的完整闭环。并且,Psi-R0还可以实现跨物品、跨场景级别的泛化。

DexGraspVLA:通用灵巧抓取大模型的里程碑

DexGraspVLA在全新实验环境以及千余种未见物体、光照、背景组合的堆叠场景中成功实现90+%的抓取成功率。其中,未见单物体基准测试成功率高达98+%,即使在多种环境干扰下,上层planner物体识别标注成功率也接近100%

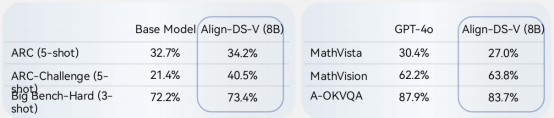

Align-DS-V是首个基于DeepSeek-671B千亿参数模型的多模态对齐架构,旨在突破传统AI模型在跨模态推理中的局限性,实现语言、视觉、动作模态的深度融合,为具身智能场景提供强推理能力支撑。该模型基于慢思考强推理能力的持续自我进化,突破了单一模态的局限性,通过深度融合世界知识,模型在文本模态下的智能边界得以大幅拓展。

Align-DS-V模型试用地址:https://ai.gitee.com/serverless-api?model=Align-DS-V

在此次大会中,王启斌表示在机器人借助DeepSeek来理解真实的物理世界的未来发展方向上仍有一段路要走。目前,人类在机器人操作层面至少有三个模态,从语言到视觉再到力交互(其中比如触觉等更复杂的模态)。从Vision到Language,如何使VLM 层面上出现推理的能力还在演进,生成式的模型比如Sora实际上只有60秒就会失忆,Google在120秒后也会出现失忆。

此外,王启斌强调DeepSeek-671B实际上是非常大的模型,而Figure已经显示了Helix里system2的大脑应该是7或者8B的模型,小脑是80M的模型,也就是说整个最后的部署在端侧。王启斌表示Figure最惊人的地方不是整个模型之间,而是它的整个大脑能做到7~9赫兹,小脑做到200赫兹。今天,灵初的水平是小脑推理层面上达到30-50赫兹,大脑一般是1赫兹,所以灵初的技术路线是在云端做训练。之后灵初相对的小模型会放在端侧做整个的Inference,这是公司认可的一条技术路径。最后,对于人形机器人的发展阶段和应用场景,王启斌表示整个embodied AI依然会遵循大模型的范式,会有一个预训练模型。预训练模型里会有很多对物体的泛化能力,以及对一些特定任务的技巧或技能。这些大语言模型在后续做下游处理任务的时候往往需要很多后训练和微调。今天,灵初智能实际上在预模型之后已经做了另外两步,我们拥有自己的外骨骼设备,在采集一比一的真机数据,去做类似于SFT的一些Fine Tuning,之后再加上真机强化。

结语:灵初智能以“技术唯一性”与“场景先行性”双轮驱动,重新定义具身智能的边界。其从算法底层到产业落地的完整闭环,不仅为开发者提供了可复用的技术底座,更为制造业升级、服务智能化注入全新动能。作为通用人工智能赛道的核心参与者,灵初智能正加速推动“机器替人”的时代到来。